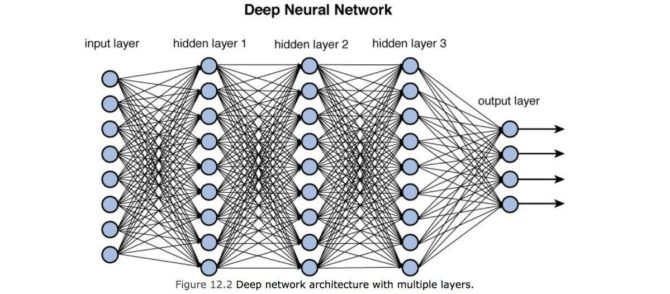

Sabemos cómo funciona el sistema de comunicación neuronal de los seres vivos. ¿Y en las máquinas? Pues también hay neuronas, neuronas artificiales. En esta red neuronal, las neuronas se agrupan en tres tipos de capas: de entrada, las neuronas solo reciben señales procedentes del entorno, no de otras neuronas; de salida, proporcionan la respuesta de la red neuronal, y ocultas, las neuronas no se conectan directamente al entorno. Las redes neuronales son sistemas de aprendizaje basados en ejemplos y en los errores cometidos durante el entrenamiento. Así, la capacidad de la red para resolver el problema dependerá del tipo de ejemplos disponibles en el proceso de aprendizaje. Algunos inconvenientes de las redes neuronales son que el tiempo de aprendizaje no se puede determinar a priori y que el diseño de la red neuronal adecuada para resolver un problema puede ser una tarea larga y compleja.

El Perceptrón, desarrollado en 1958 por Frank Rosenblatt (en la imagen de cabecera), es una red neuronal artificial de una sola neurona. Más tarde aparecieron las redes neuronales multicapas o perceptrón multicapa. Esta es la base del Deep Learning o aprendizaje profundo; es decir, del aprendizaje automático o de máquina sin guía o supervisión (por oposición al Supervised Learning).

|

| Redes neuronales profundas - Tipos y características, codigofuente.org |

El Deep Learning tiene ya numerosas aplicaciones. Por ejemplo, en la conducción autónoma, la seguridad, la traducción, la sanidad o el procesamiento de imagen. Pero las redes neuronales presentan todavía dos problemas, como hemos visto en la clase 8. Uno es que no proporcionan ninguna justificación de por qué han obtenido determinado resultado y no otro. Es decir, nos hallamos ante un sistema de toma de decisiones más bien opaco e inaccesible. En ese sentido escriben los investigadores Senén barro y José María Alonso el artículo 'Las inteligencias artificiales deberían poder razonar sus explicaciones': «Por muy capaces que sean las máquinas para darnos respuestas, si estas nos afectan significativamente necesitamos que, además de ser buenas, sean entendibles. De otro modo no confiaremos en ellas. Se trata de un tema que está cada vez más presente en el marco legislativo de los países. De hecho, el nuevo Reglamento General Europeo de Protección de Datos otorga el derecho a una explicación de las decisiones que afectan a las personas, sin importar quién (o qué máquina) tome esas decisiones. Además de las cuestiones técnicas y jurídicas, también hay que tener en cuenta las cuestiones éticas, como se destaca en las directrices para una IA digna de confianza publicadas por la Comisión Europe».

Otro problema es que no se adaptan al cambio de 'escenario'. Por ejemplo, a la variación de tamaño de un tablero de juego. Por tanto, no funcionan bien en entornos poco predecibles.

Además, como se ha indicado al principio, la capacidad de la red para resolver el problema dependerá del tipo de ejemplos disponibles en el proceso de aprendizaje. Como apunta Pablo Rodríguez Canfranc en 'Las limitaciones del aprendizaje profundo', «en la medida en que un sistema se enfrente a un input del que no ha tenido un ejemplo previo, por ejemplo, una foto o una palabra, y se ve obligado a extrapolar en base a datos genéricos, los resultados que ofrezca pueden resultar más imprecisos. Puede ser, por ejemplo, una determinada pronunciación que un sistema de reconocimiento del lenguaje no tiene registrada y que le haga confundir una palabra o expresión por otra». Por lo tanto, si para determinado problema no hay disponibles grandes cantidades de datos, el Deep Learning no es la mejor opción.

Resulta interesante leer este breve artículo, donde se relatan los errores cometidos por una red neuronal en cinco experimentos con imágenes. También podemos consultar el trabajo del científico Gary Marcus 'Deep Learning: A Critical Appraisal', en el que enumera un total de diez desafíos a los que se enfrentan los sistemas de aprendizaje profundo.

Julián Estévez Sanz, de la Universidad del País Vasco, afirma que «las técnicas que están más de moda, como el famoso deep-learning, ya están dando muestras de agotamiento» y plantea una alianza entre la neurociencia y la psicología para «arrojar luz sobre nuevos algoritmos de IA».

Comentarios

Publicar un comentario